人工智能技术的强力引擎,HBM推动算力需求爆发式增长

作者:马渭淞 编辑:郝科科、常飞特

在11月13日,英伟达在S23大会上发布了下一代AI芯片NVIDIA HGXH200,其升级重点为搭载全新HBM3e内存。AI算力催化下HBM需求爆发式增长。据慧聪电子,2023年开年后三星、SK海力士两家存储大厂HBM订单就快速增加,价格也水涨船高,据悉近期HBM3规格DRAM价格上涨5倍。该行认为算力需求带动HBM爆发式增长。

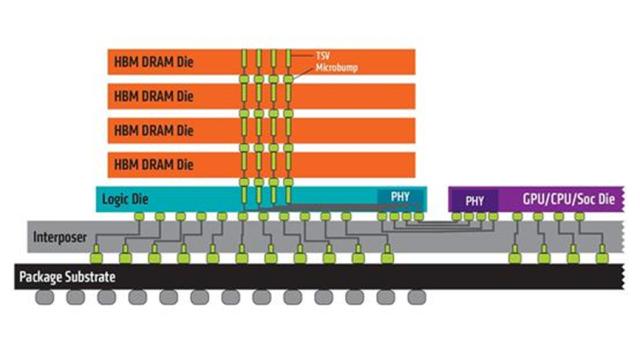

所谓HBM(High Bandwidth Memory )是一款新型的CPU/GPU 内存芯片(即 “RAM”),其实就是将很多个DDR芯片堆叠在一起后和GPU封装在一起,实现大容量,高位宽的DDR组合阵列。

HBM构造视图

换句话说,HBM就像一条高速公路,连接着芯片的各个部分,让数据可以更快地进出。想象一下,如果原来的内存就像一条单车道的小路,虽然可以通行,但速度非常慢。而HBM就像是一条宽阔的八车道高速公路,可以让数据更快地到达目的地。

HBM通过将多个存储芯片堆叠在一起,就像是把一条条小路连接起来,形成了一条宽阔的超级高速公路。这不仅能够大幅度提高数据处理速度,还能够增加内存容量,就像是把原来的小房子换成了大别墅,可以容纳更多的数据。

所以,HBM是一种革命性的技术,它能够让芯片的性能得到大幅提升,为各种应用提供了更强大的支持。

总的来说,HBM作为一种高性能内存解决方案,通过提供高带宽、低延迟和并行传输等特性,为人工智能技术的发展提供了强有力的支持。它使得人工智能模型能够更快地进行训练和推理,从而推动了人工智能技术在各个领域的广泛应用。

HBM,人工智能技术的强力引擎

尤其在人工智能研发领域,HBM解决了该领域核心驱动力,即算力的需求。

首先我们需要了解人工智能技术的核心驱动力——算力。随着人工智能算法的不断复杂化,模型规模越来越大,需要更多的计算资源来满足实时处理的需求。这其中,内存带宽成为限制算力提升的关键因素之一。如果内存带宽不足,那么处理器需要等待数据从内存中读取或写入,这会浪费大量的时间并限制了人工智能系统的性能。

这就好比人工智能是一位厨师长,处理复杂的菜肴(数据)。但助手(内存)找到正确的“食材”(数据)太慢,导致大厨要等很久。这个等待时间就是“内存带宽”,它代表了数据传输的速度。如果速度慢,大厨(处理器)就要等更久。所以,提升“找菜速度”(内存带宽)可以提高大厨的“烹饪速度”(算力),加快人工智能模型的训练和推理。

在此当中,HBM采用堆叠DRAM技术,将多个DRAM芯片垂直堆叠在一起,并通过先进的封装技术将它们与GPU或其他计算芯片相连。这种设计大大提高了内存带宽。与传统的DRAM相比,HBM的带宽提升了数倍,从而使得人工智能模型的训练和推理速度得到了显著提升。

换句话说,HBM扮演了助手的角色,它通过采用堆叠DRAM技术,将多个DRAM芯片垂直堆叠在一起,并通过先进的封装技术将它们与GPU或其他计算芯片相连。这种设计大大提高了内存带宽,从而减少了“找菜时间”,让大厨(处理器)能够更快地处理数据。

因此,HBM的高带宽特性可以满足人工智能模型对大量数据的快速处理需求。在训练人工智能模型时,HBM可以提供更快的内存访问速度,从而提高训练速度。同时,HBM的低延迟特性使得数据可以更快地从内存传输到计算单元,从而减少等待时间并提高计算效率。这对于人工智能大模型的推理过程尤为重要,因为该技术需要实时响应并处理大量数据。

多国积极拓展,产业界仍需冷静

随着HBM技术的价值被发掘,目前各主要芯片制程厂商均在积极布局。其中台积电正大举扩充SolC系统整合单芯片产能,正向设备厂积极追单,预计今年底的月产能约1900片,明年将达到逾3000片,2027年有机会提升到7000片以上。值得注意的是,台积电SolC是业界第一个高密度3D小芯片堆叠技术,公司扩产此举主要意在应对AI等领域的旺盛需求。

此外据报道,SK海力士已开始招聘逻辑芯片 (如CPU、GPU) 设计人员,计划将HBM4通过3D堆叠直接集成在芯片上。SK海力士正与英伟达等多家半导体公司讨论这一新集成方式。据SK海力士预测,HBM市场到2027年将出现82%的复合年增长率。

截至2022年,HBM市场主要被全球前三大DRAM厂商占据,其中海力士HBM市占率为50%,三星的市占率约40%、美光的市占率约10%。

与此同时,国内相关厂商则主要处于HBM上游设备和材料供应环节。其中,华海诚科2023年8月投资者关系活动记录显示,公司的颗粒状环氧塑封料(GMC)可以用于HBM的封装,相关产品已通过客户验证,现处于送样阶段。截至11月20日,公司股价11月以来已经翻两倍。

此外,联瑞新材的部分客户是全球知名的GMC供应商,他们需要使用颗粒封装材料来提升封装高度和满足散热需求。据海力士公开披露,球硅和球铝是升级HBM的关键材料。而联瑞新材也已开始配套生产HBM所用的球硅和球铝。

因此,虽然眼下HBM的市场基本被海外巨头所占据。但随着ChatGPT的AI大模型问世,百度、阿里、科大讯飞、商汤、华为等科技巨头纷纷要训练自己的AI大模型,AI服务器的需求大幅度激增。这也意味着,芯片储存的自主可控仍是当下产业发展的重要方向。所以在未来HBM国产化也将成为大的发展趋势。

但值得注意的是,HBM 虽好但国内产业界仍需冷静对待。这是因为HBM 现在依旧处于相对早期的阶段,其未来还有很长的一段路要走。但可预见的是,随着人工智能产业的迅速发展以及相关技术的频繁迭代,内存产品设计的复杂性注定会快速上升,并对带宽提出了更高的要求,进而不断上升的宽带需求将持续驱动 HBM 发展。

而对于该产业在二级市场的发展,中银国际方面则表示,伴随AI大模型训练的不断推进,HBM作为关键性技术,其增长确定性极高,相关投资机会有望集中在封装设备材料及国产HBM配套供应。

(来源金融界)市场观察所刊载信息,来源于网络,并不代表本媒体观点。本文所涉及的信息.数据和分析均来自公开渠道,如有任何不实之处、涉及版权问题,请联系我们及时处理。本文仅供读者参考,任何人不得将本文用于非法用途,由此产生的法律后果由使用者自负。投诉举报请联系邮箱:News_Jubao@163.com

聚焦商业经济报告和前瞻商业趋势分析,市场观察非新闻媒体不提供互联网新闻服务;